Deepseek是杭州深度求索公司开发的大语言模型,包含基础模型和代码模型。基础模型有7B和67B参数版本,7B版本在主流英文和中文基准测试中表现出色;67B版本则在多个基准测试中优于GPT-3.5 Turbo。代码模型有1.3B、7B和67B三种参数规模,在多个代码评测基准上有卓越表现,如7B代码模型在HumanEval基准测试中以65%的通过率超越GPT-3.5 Turbo,67B代码模型以82.7%的通过率超越GPT-4。

Dify 是一款开源的大语言模型(LLM) 应用开发平台。它融合了后端即服务(Backend as Service)和 LLMOps 的理念,使开发者可以快速搭建生产级的生成式 AI 应用。即使你是非技术人员,也能参与到 AI 应用的定义和数据运营过程中。

Dify最牛的地方就是像搭积木一样简单——不用懂代码,普通人稍微学学就能用它的「智能机器人」和「流程图」功能,自己拼出一套自动化工具。比如自动回复客户、处理文件这些事,你拖拖拽拽就能搭出想要的功能,特别适合折腾些好玩的小发明。我们可以通过智能体或工作流,自定义工具完成很多我们好玩的功能。报文篇幅较长,简单说下内容:从0开始创建一个票务识别智能体;介绍搭建过程中的各个细节;教会你每一步为什么,而不是只是完成;通过实践这个流程,我相信你可以学会自己搭建自己需要的智能体。

deepseek私有化部署

首先下载并安装Ollama

参考官网即可

https://ollama.com/安装deepseek

打开Ollama官网首页,在搜索框里输入deepseek-r1,你会发现这个模型排在第一个位置,热度相当高。模型有多个版本,比如1.5b、7b、8b等,数字越大,模型越强大,但对硬件要求也越高。

根据你的电脑配置选择合适的模型版本。一般来说,8b是一个比较平衡的选择,既能保证性能,又不会对硬件要求太高。如果你有高性能显卡,当然可以选择更大的模型。笔者显卡是4070super。由于硬盘容量不足,部署的7B版本。

1 | ollama run deepseek-r1:7b |

这个过程类似于Docker拉取镜像,耐心等待即可。

安装完成就自动启动了。

dify安装部署

笔者是windows系统,已经安装了docker desktop。

然后直接访问它的GitHub仓库(https://github.com/langgenius/dify),获取最新版本。解压缩后,进入项目根目录,找到docker文件夹。

拉取镜像并启动

1 | docker compose up -d |

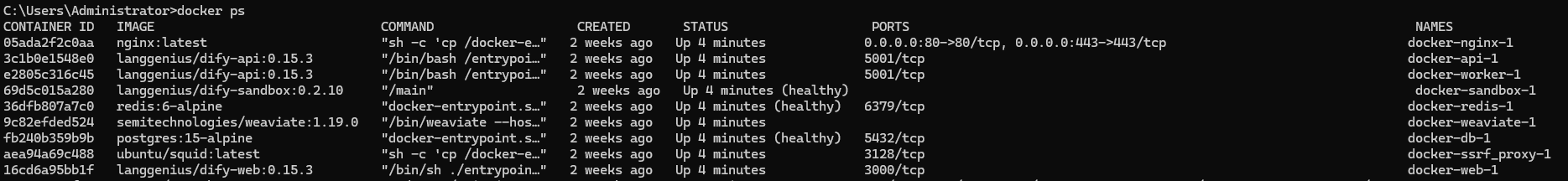

安装完之后,查看:

初始化:在浏览器地址栏输入以下地址:

1 | http://127.0.0.1/install |

按照提示完成安装并登录账号,进入Dify的主页。

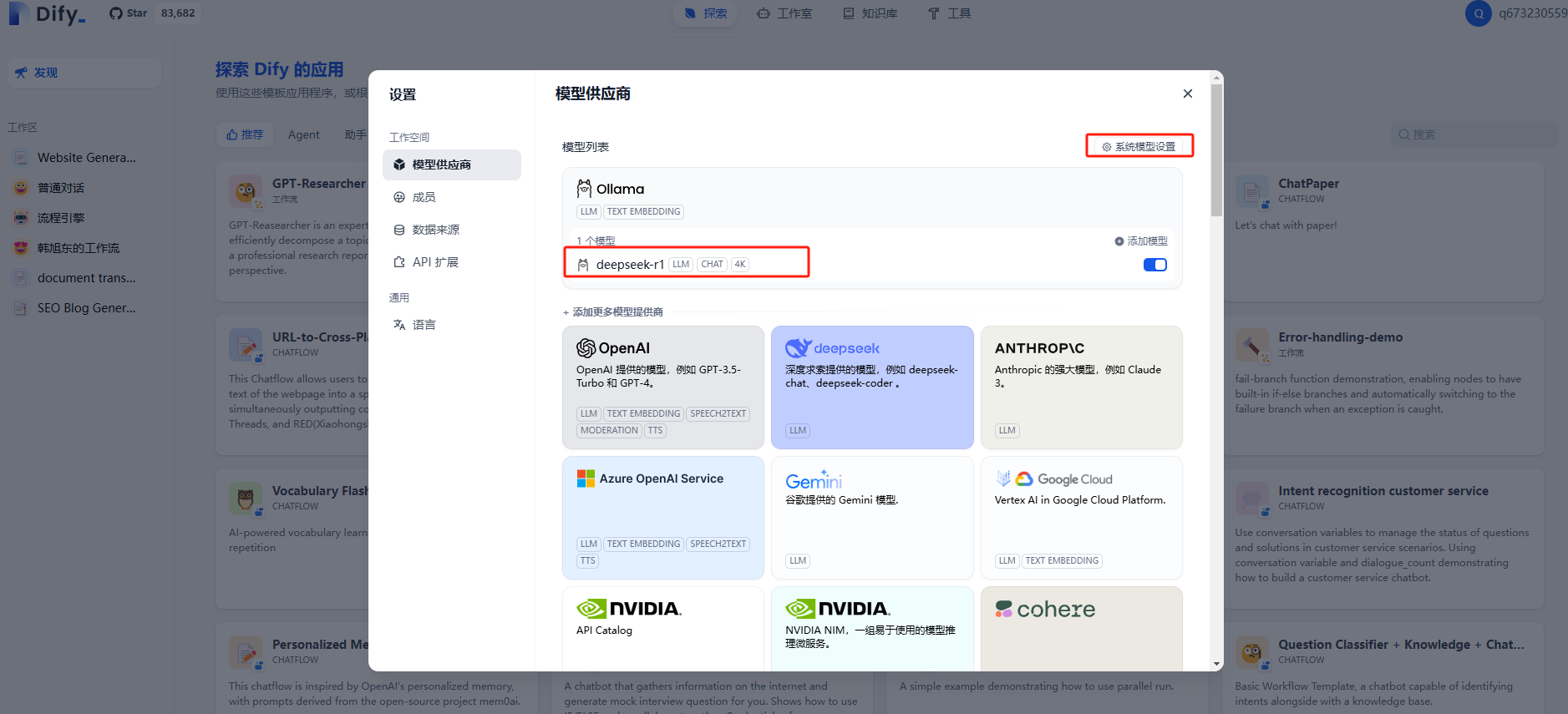

关联本地大模型与Dify

界面

界面如下:

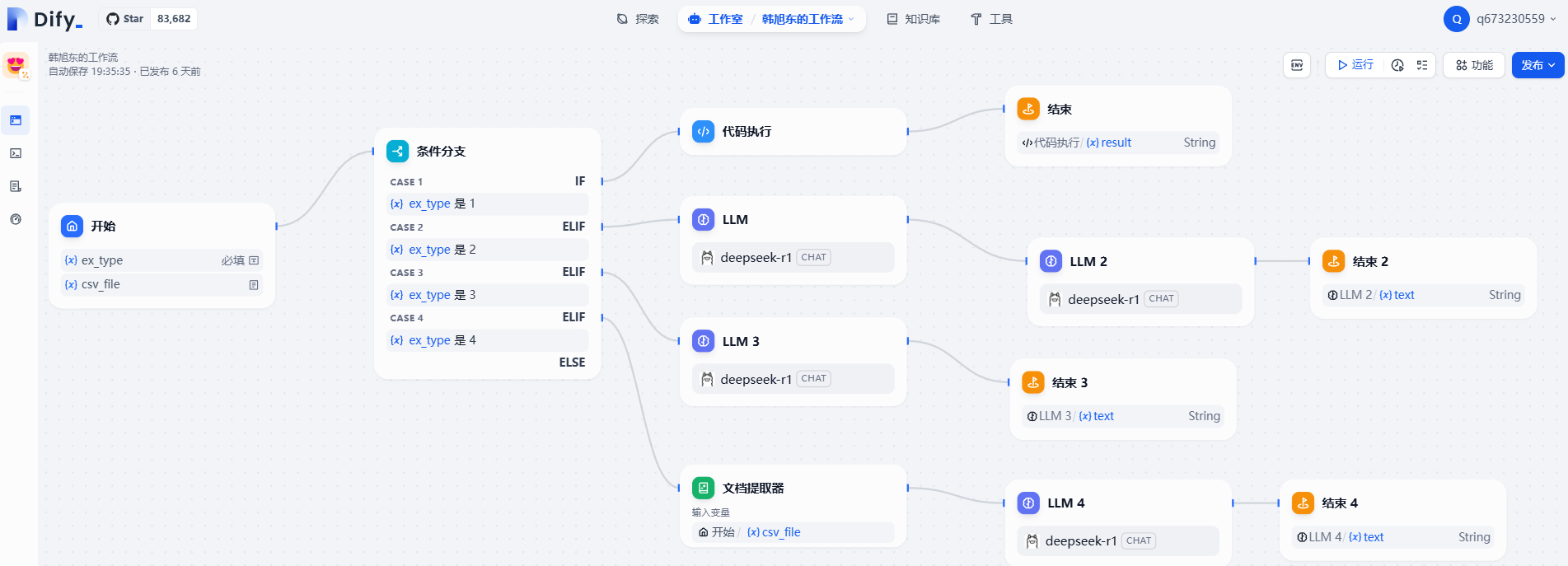

新建智能体(工作流)

智能体配置

- 开始,可以配置入参,文件,图片等

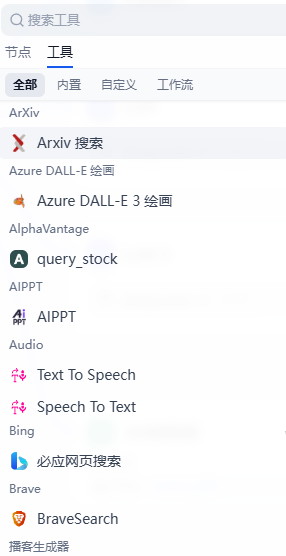

- 节点类型

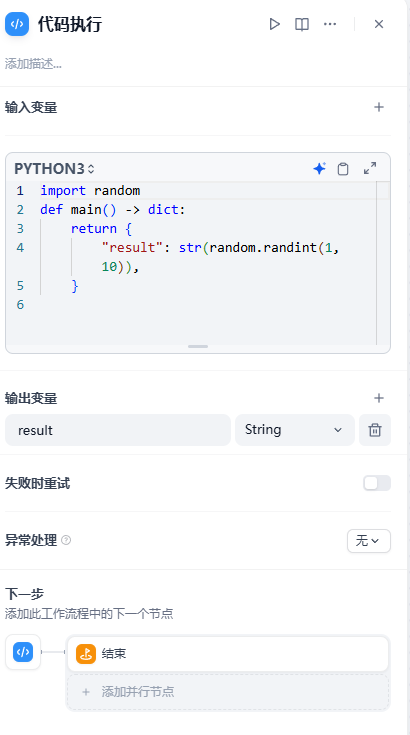

- 比如python代码节点

- 配置python代码

- 开始,可以配置入参,文件,图片等

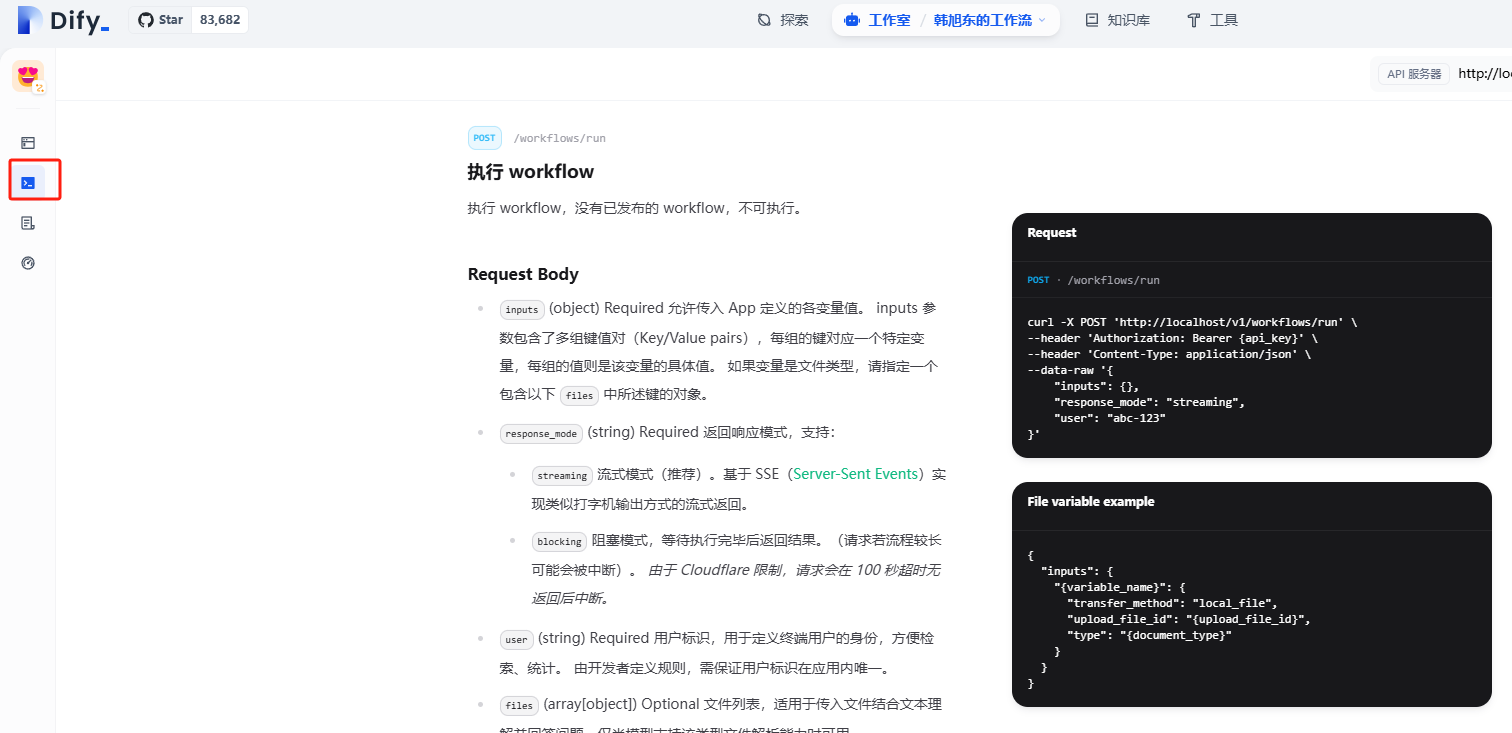

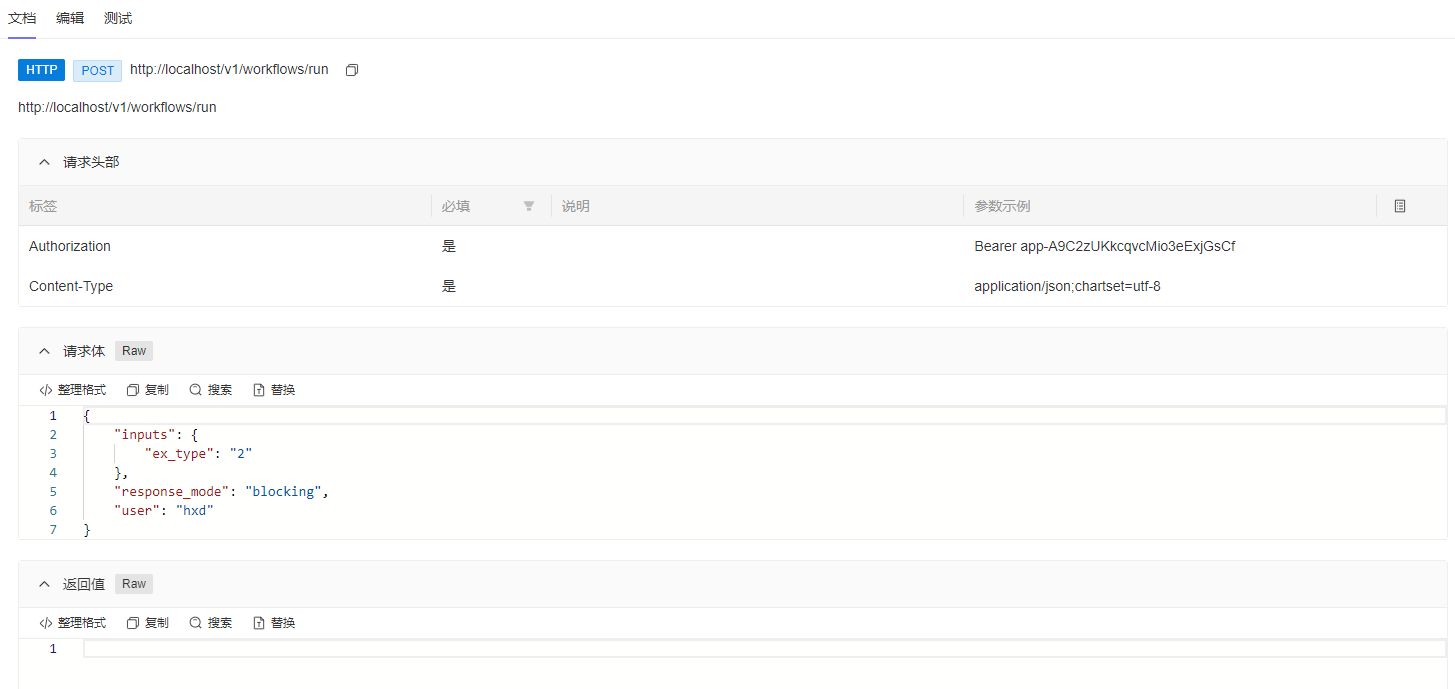

提供对外接口

api调用

可以实现什么功能

- 自定义工作流,解决重复流程问题

- 二次开发更复杂能力的节点,实现个性化方案

- 对外提供服务,监控服务

- 创建智能体应用

最重要的点

- 要会用提示词

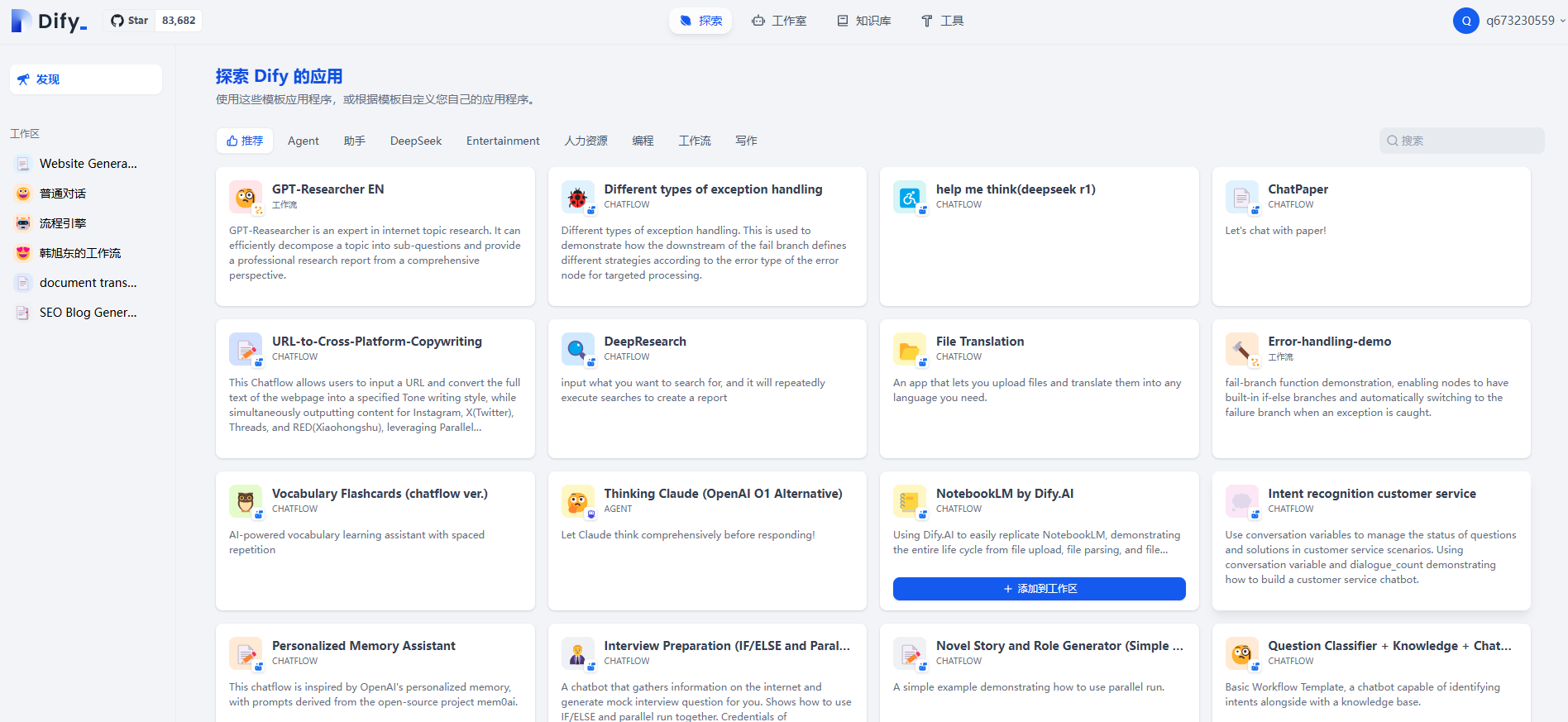

附录:根据提供的智能体学习智能体

首页提供了很多智能体,可以添加到工作空间,学习每个节点组件怎么使用

附录:dify结构梳理

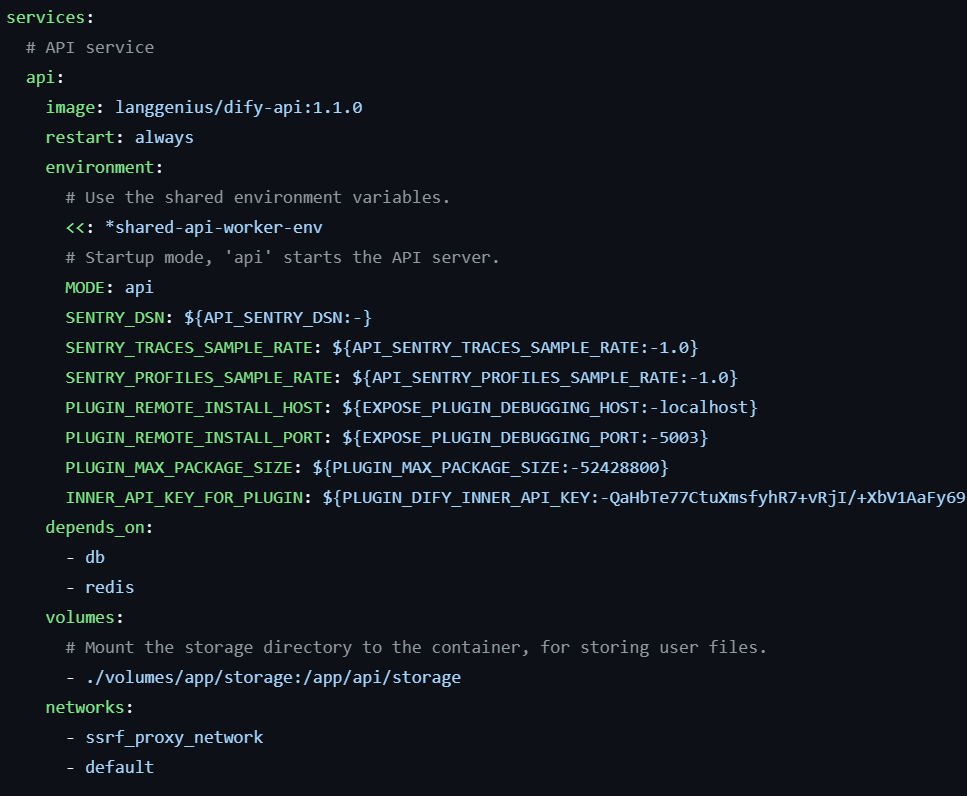

api服务

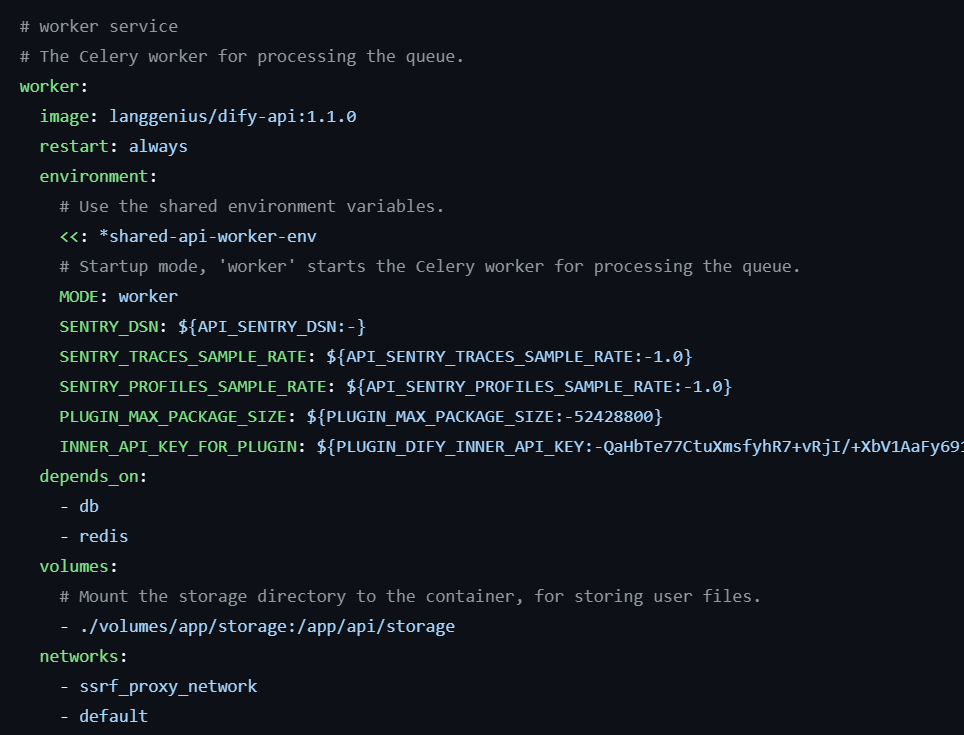

worker服务

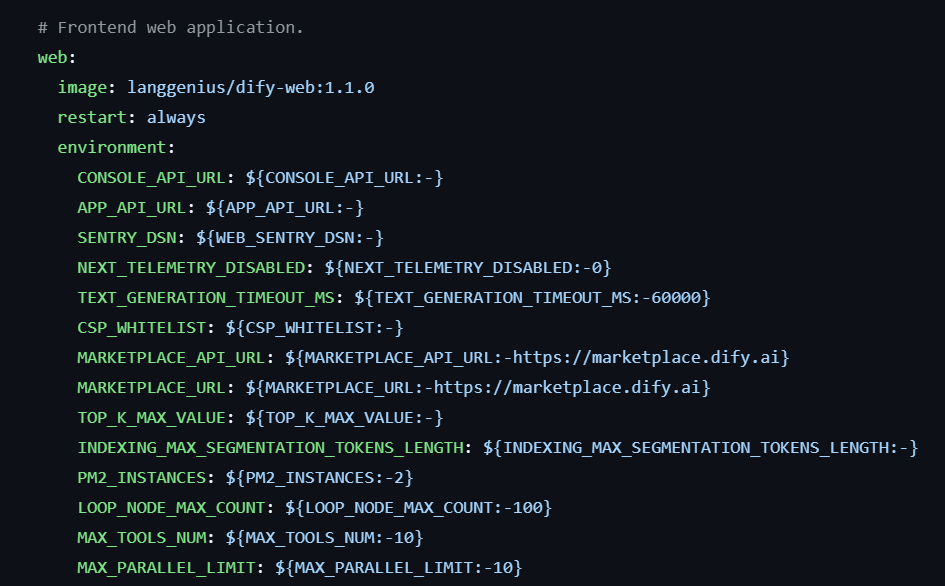

web服务

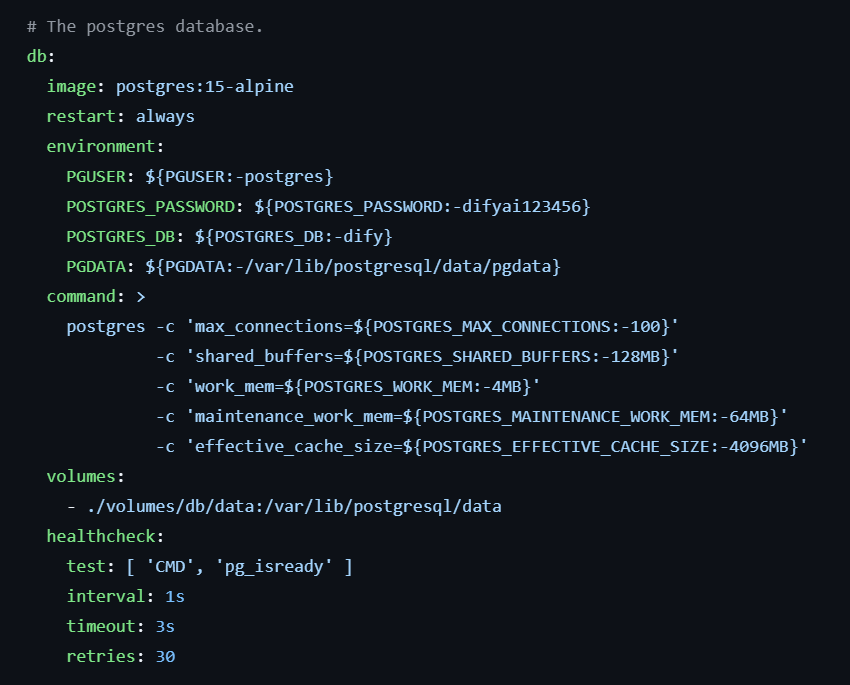

db-postgresql服务

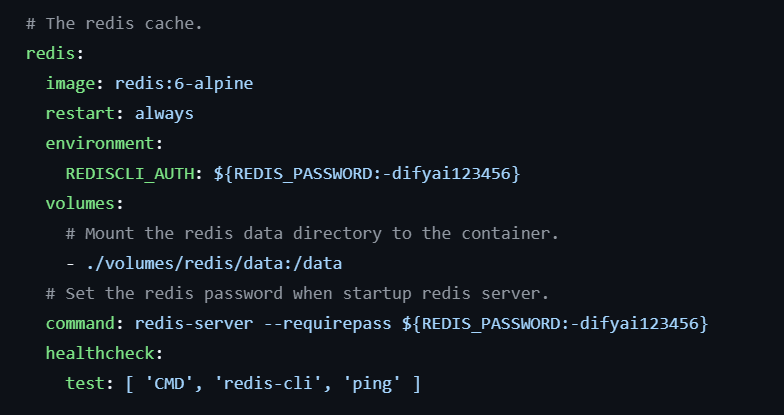

redis服务

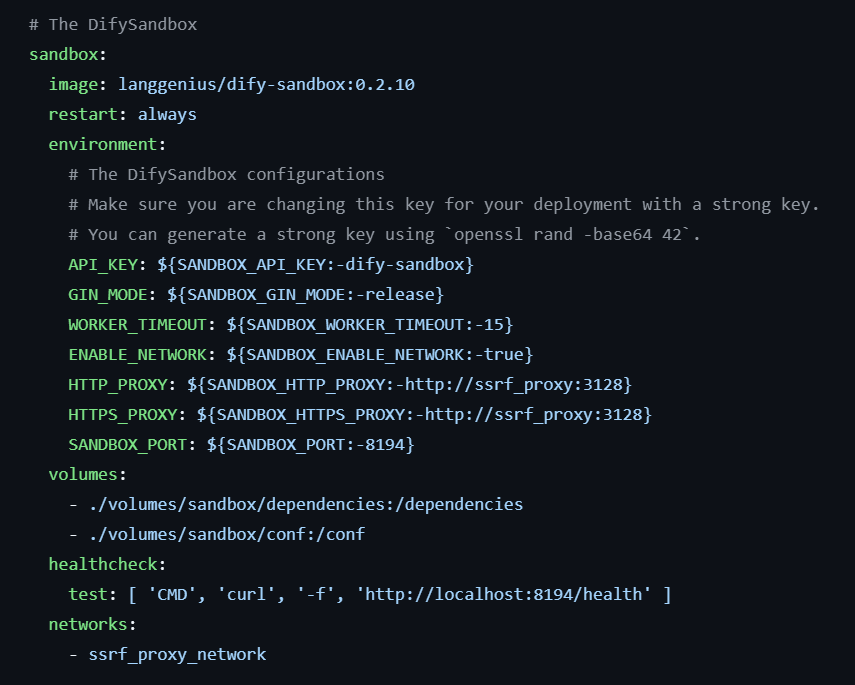

sandbox服务

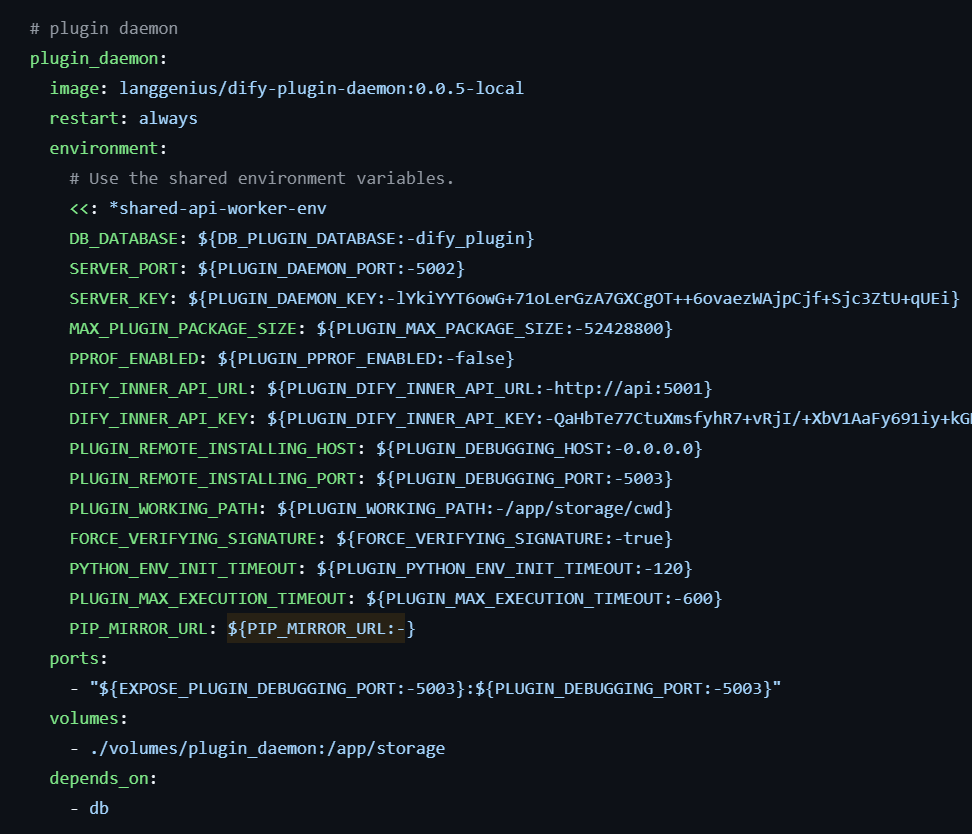

plugin_daemon服务

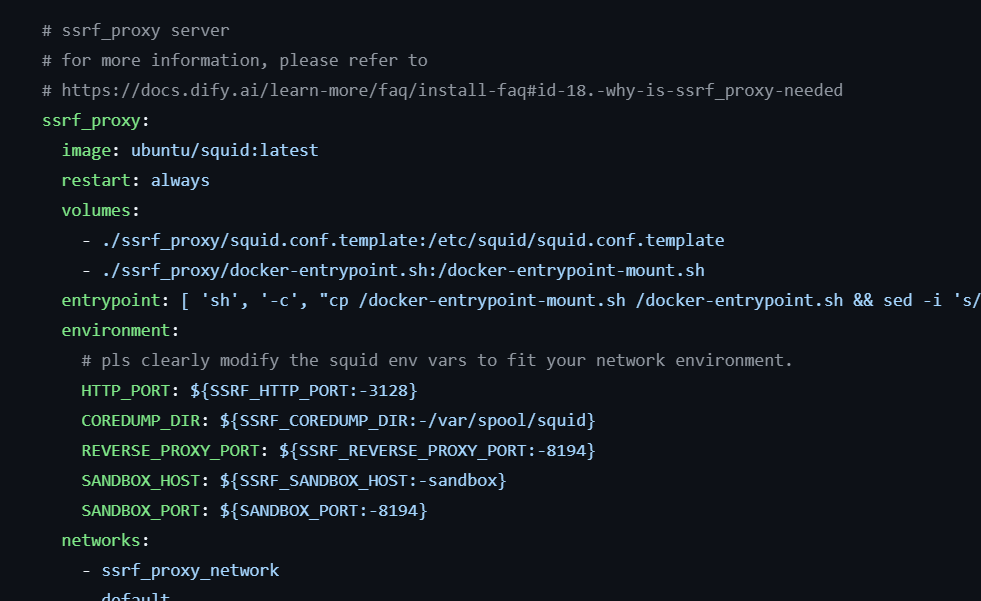

ssrf_proxy服务

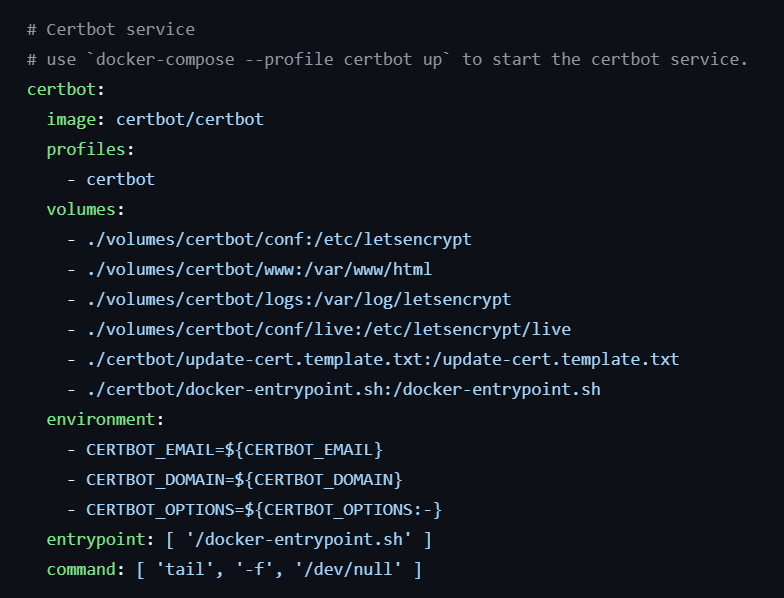

certbot服务

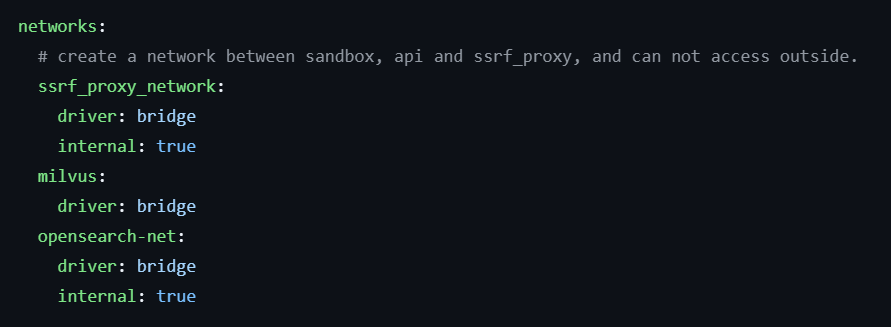

网络

- 本文标题:DeepSeek+Dify 工作流

- 本文作者:形而上

- 创建时间:2025-02-10 13:13:00

- 本文链接:https://deepter.gitee.io/2025_02_10_deepseek_dify/

- 版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!